Alegând aceeași zonă (Șoseaua Virtuții) ca în cazul semaforului tradițional, am testat abordarea noastră de învățare prin întărire (RL) aplicând-o într-un mediu mai complex, unde mai mulți agenți, câte unul pentru fiecare intersecție, acționând ca controlori ai semafoarelor într-o rețea rutieră, lucrează simultan și în armonie pentru a produce un rezultat eficient.

Acești controlori învață să gestioneze traficul mai eficient pe măsură ce simularea progresează. Vom prezenta o revizuire a rețelei rutiere și vom discuta rezultatele.

1. Flux cu densitate scăzută

2. Flux cu densitate ridicată

Este evident că aproape nu există diferențe între fluxurile de trafic cu densitate scăzută și ridicată, deoarece managementul traficului este cu adevărat eficient.

Chiar dacă numărul de mașini din simulare a crescut semnificativ, am observat că acest lucru nu a afectat eficacitatea sistemului. Sistemul a continuat să gestioneze traficul eficient, menținând un flux fluid al traficului, în ciuda volumului mai mare de vehicule.

În plus, comparând simulările aceleiași zone folosind două scripturi diferite—unul pentru trafic cu densitate scăzută și altul pentru trafic cu densitate ridicată—sistemul s-a adaptat bine la ambele condiții. În ambele cazuri, timpul mediu de așteptare la intersecții a fost minim, iar congestia traficului a fost constant scăzută, așa cum se demonstrează în ambele simulări.

Interpretarea rezultatelor

• Ca rezultat al simulării grafice, se vede clar că congestia a fost redusă și nu există rute congestionate semnificative, iar timpul de așteptare a fost optimizat prin faptul că nu se așteaptă lumina verde de pe o bandă goală.

Modelul antrenat prin Q-Learning sa dovedit a fi eficient și capacitatea sa de a se adapta la condiții complexe de trafic a demonstrat acest lucru în diverse scenarii de simulare, crescând constant fluxul de vehicule și evidențiind performanța în comparație cu metodele tradiționale de control al traficului.

Prin interacțiunea cu fluxul de trafic la intersecțiile lor respective, controlorii semafoarelor (agenții Q-Learning) colectează date și își ajustează temporizarea semnalelor pentru a optimiza condițiile de trafic în timp.

Cu alte cuvinte, simularea le permite acestor controlori să învețe continuu și să-și îmbunătățească capacitatea de a reduce congestia și de a îmbunătăți fluxul de trafic în întreaga rețea.

Agentul de Q-Learning a demonstrat o competență totală în controlul semafoarelor, răspunzând eficient la diverse situații de trafic ( de ex. Accidente ).

Acest lucru este evidențiat de recompensa cumulativă ridicată, care servește drept cel mai important indicator al învățării reușite în metoda aleasă de noi. Creșterea recompensei cumulative în timp confirmă că agentul și-a optimizat politica (alegând cele mai bune acțiuni) pentru managementul traficului, reducând eficient congestia și timpii de așteptare.

Prin urmare, putem concluziona că ne-am atins cu succes obiectivul principal.

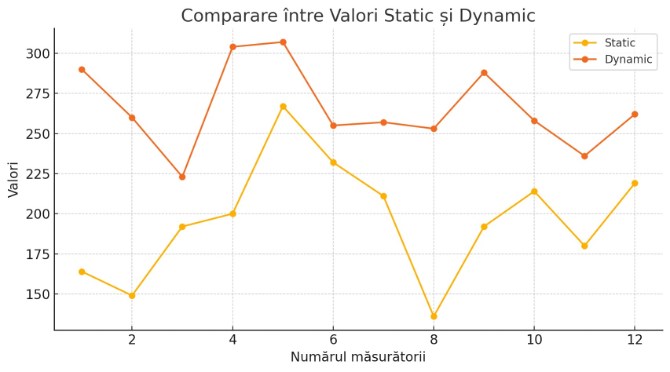

Analiza și compararea rezultatelor

După ce agenții au fost antrenați cu succes, cu scopul general de a reduce congestia traficului și a minimiza timpii de așteptare ai vehiculelor, această secțiune se concentrează pe analizarea rezultatelor.

Vom compara, de asemenea, performanța agenților antrenați în mediul Pygame cu sistemul multi-agent din SUMO.

În plus, mai jos este prezentată și o comparație detaliată între sistemele tradiționale de control al traficului și abordările inteligente de management al traficului, evidențiind eficiența lor respectivă în gestionarea fluxului de trafic.

Iată rezultatul simulării cu 95 de rulări și fiecare rulare cu 8 episoade:

Agentul este antrenat printr-un număr de rulări, fiecare rulare conținând episoade. Am reprezentat grafic rezultatele mediei celor 95 de rulări. Este clar că agentul învață în timp să regleze mai bine congestia pe măsură ce progresează.

Cu toate acestea, putem observa că agentul poate încă lua decizii mai puțin precise, ducând la o creștere a timpului de așteptare. Acest lucru ar putea fi cauzat de motive precum încercarea de acțiuni aleatorii pentru a vedea dacă duc la rezultate mai bune.

Leave A Comment